Premio a la mejor tesis doctoral en IA para Arquímides Méndez Molina, egresado del doctorado en Ciencias Computacionales

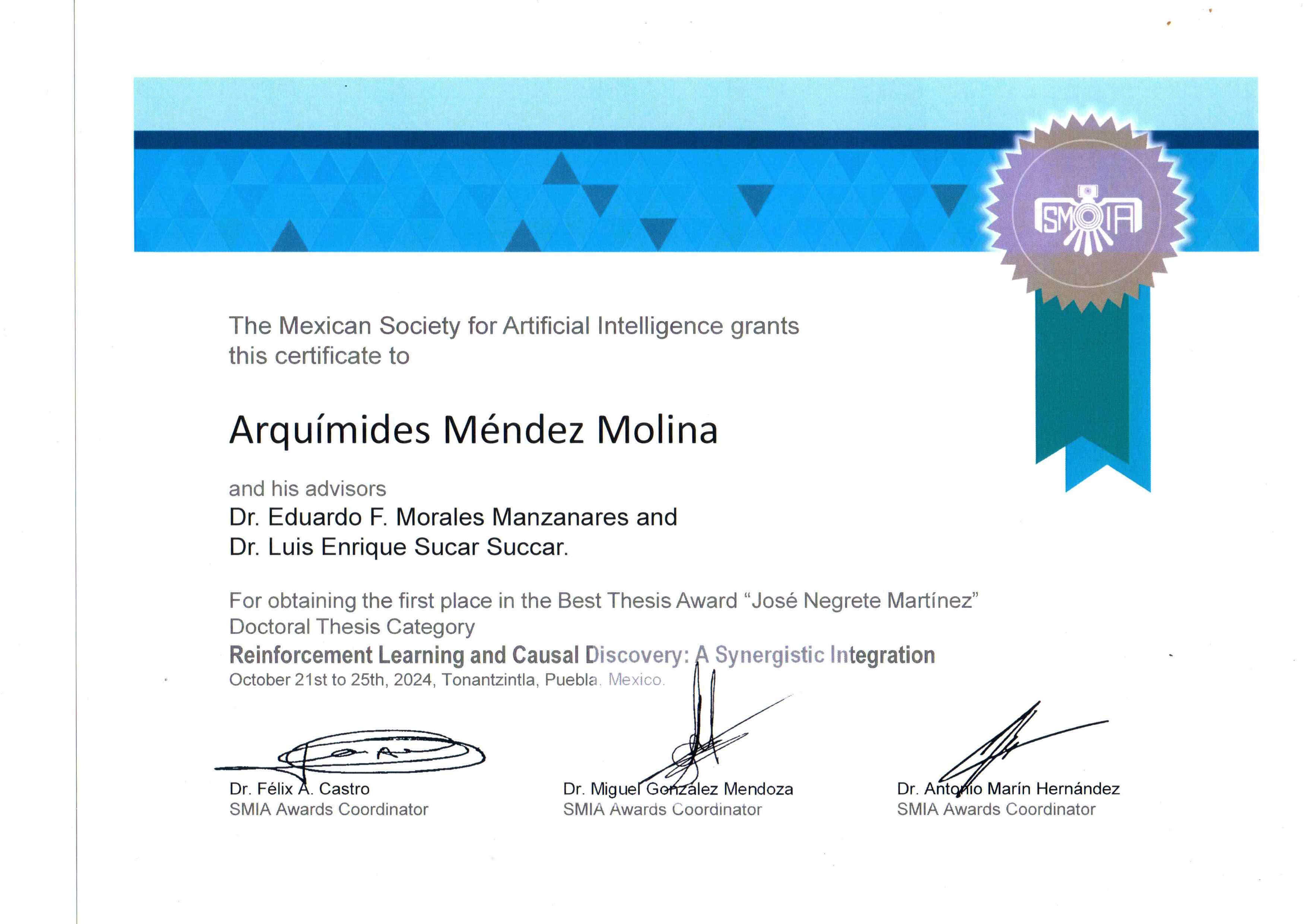

Arquímides Méndez Molina, egresado de la maestría y del doctorado en Ciencias Computacionales del Instituto Nacional de Astrofísica, Óptica y Electrónica (INAOE), obtuvo el Premio “José Negrete Martínez” otorgado por la Sociedad Mexicana de Inteligencia Artificial (SMIA) a la mejor tesis doctoral del área.

El trabajo de investigación, titulado "Reinforcement Learning and Causal Discovery: A Synergistic Integration", fue asesorado por los doctores Eduardo Morales Manzanares y Luis Enrique Sucar Succar, investigadores de la Coordinación de Ciencias Computacionales del INAOE.

El Premio “José Negrete Martínez” a la mejor tesis de doctorado fue otorgado por la SMIA en el marco de la Conferencia Internacional Mexicana de Inteligencia Artificial (MICAI 2024) que se realizó en octubre en el INAOE.

En un correo electrónico, el ahora Dr. Arquímides Méndez Molina relata que es originario de Camagüey, Cuba. Se graduó de la carrera de Ingeniería Informática en la Universidad de Camagüey en 2013. Entre ese año y 2016 se desempeñó como profesor en la misma institución.

En 2016 profesores del INAOE acudieron a su universidad a aplicar los exámenes de admisión para el Maestría en Ciencias Computacionales, y Arquímides los aprobó. Interrogado sobre por qué tomó la decisión de dedicarse a las Ciencias Computacionales, y específicamente a la IA, explica: “Principalmente por las pláticas de los profesores del INAOE sobre el programa de maestría, donde pude apreciar el alcance de los temas y la calidad y prestigio de la institución. A pesar de que mi carrera de licenciatura estuvo más relacionada con la producción de software para la industria, siempre tuve gran inclinación hacia los temas de algoritmos, inteligencia artificial y ciencias computacionales en general. Por otra parte, también fue determinante saber del apoyo económico por parte de Conahcyt a los estudiantes extranjeros, así como las facilidades que brindaba el gobierno de México para poder traer a mi familia conmigo. Una vez dentro de la maestría rápidamente me fui inclinando por los temas de Inteligencia Artificial (que es el área con más materias dentro del programa) especialmente por el área de Aprendizaje por Refuerzo y los Modelos Gráficos Probabilísticos con foco en las aplicaciones para Robótica”.

El Dr. Méndez Molina agrega que la tesis premiada es el resultado de casi cinco años de investigación bajo la asesoría de los doctores Eduardo Morales Manzanares y Luis Enrique Succar, en ella se proponemos una novedosa manera de integrar el Aprendizaje por Refuerzo (RL) con el Descubrimiento Causal (CD).

“Por una parte, el Aprendizaje por Refuerzo (RL) es una técnica que permite entrenar sistemas autónomos para tomar decisiones óptimas con el objetivo de maximizar recompensas futuras, aprendiendo de la interacción con su entorno, de forma similar a cómo los humanos aprenden de la experiencia. En años recientes, la combinación de RL con redes neuronales profundas ha generado avances notables en áreas como la robótica, los videojuegos, el procesamiento de lenguaje natural, la economía y la salud. Ejemplos destacados incluyen algoritmos que han superado a jugadores humanos en videojuegos de Atari y en juegos complejos como Go y Ajedrez. Sin embargo, RL aún enfrenta importantes desafíos, como los largos tiempos de cómputo requeridos para alcanzar niveles altos de desempeño y la dificultad de identificar relaciones de causa y efecto más allá de simples asociaciones estadísticas, lo que limita su aplicación en problemas del mundo real.

“Por su parte, el Descubrimiento Causal (CD) es un enfoque que busca descubrir relaciones causa-efecto entre variables. Esto permite responder preguntas más complejas que las tradicionales basadas únicamente en la observación, como predecir el resultado de una intervención (alterar deliberadamente una variable) o evaluar escenarios alternativos que nunca han ocurrido (contrafactuales). Sin embargo, el descubrimiento causal enfrenta sus propios retos, como la dificultad para recopilar suficientes datos, la influencia de variables ocultas y la necesidad de realizar intervenciones que pueden ser costosas o incluso inviables, especialmente en áreas como la medicina.

“El objetivo principal de nuestra investigación fue combinar RL y CD para que ambos se complementen y fortalezcan mutuamente. Para ello, desarrollamos un framework llamado CARL (Causality-Aware Reinforcement Learning). Con CARL, los agentes inteligentes entrenados con RL logran reducir significativamente el número de interacciones necesarias con el entorno para aprender una tarea. Esto es posible ya que, durante el proceso, los agentes aprenden y utilizan un modelo causal que describe las relaciones entre las variables del entorno y del propio agente. Estos modelos causales pueden reutilizarse en tareas similares, mejorando la eficiencia y transferencia del aprendizaje.

“Nuestro método fue formalizado de manera que su aplicabilidad potencial trascienda los ejemplos utilizados en escenarios de prueba, abriendo oportunidades en múltiples dominios del mundo real”.

Finalmente, el Dr. Arquímides Méndez Molina comenta que actualmente trabaja de manera independiente en un emprendimiento de software para proveer un servicio de automatización de tareas y datos periódicos de interés extraídos de Internet: “A futuro tengo la intención de constituir mi propia empresa, integrarme al sistema nacional de investigadores y probablemente a alguna institución donde retomar la docencia y la investigación”.

Luis Enrique Erro # 1, Tonantzintla, Puebla, México, Código Postal 72840, Tel: (222) 266.31.00, difusion@inaoep.mx

This work is licensed under a Creative Commons Attribution-NonCommercial-NoDerivs 2.5 Mexico License.